自从生成式人工智能出现以来,大型语言模型(LLM) 已经征服了世界并进入了搜索引擎。

但是,是否有可能通过大型语言模型优化(LLMO)或生成式 AI 优化(GAIO)主动影响 AI 性能?

本文讨论了SEO的不断发展的前景以及人工智能搜索引擎中 LLM 优化的不确定未来,并提出了数据科学专家的见解。

什么是 LLM 优化或生成式 AI 优化 (GAIO)?

GAIO 旨在帮助公司将其品牌和产品定位在 GPT 和 Google Bard 等领先的 LLM 输出中,因为这些模型可以影响许多未来的购买决策。

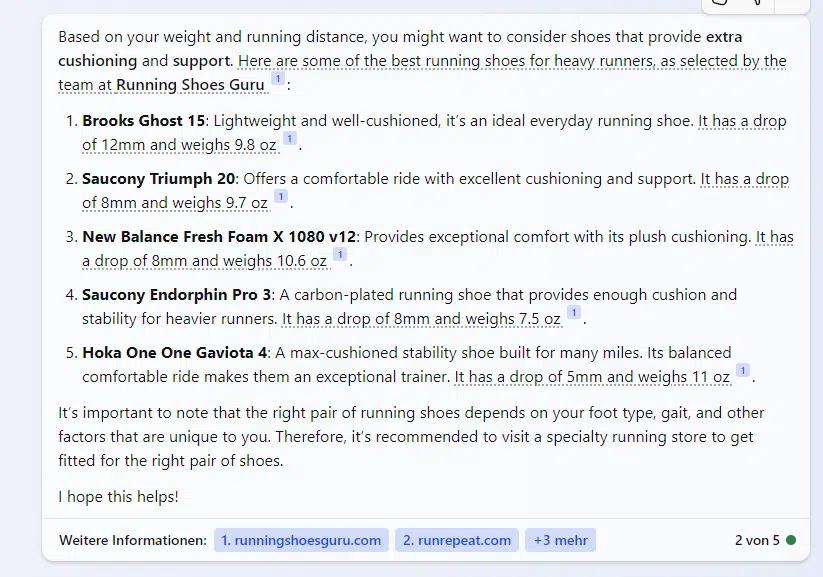

例如,如果您在 Bing Chat 上搜索适合体重 96 公斤、每周跑步 20 公里的跑步者的最佳跑鞋,系统会推荐 Brooks、Saucony、Hoka 和 New Balance 鞋。

当你向必应聊天询问安全、适合家庭、空间足够购物和旅行的汽车时,它会推荐起亚、丰田、现代和雪佛兰车型。

LLM优化等潜在方法的做法是在处理相应的交易导向问题时优先考虑某些品牌和产品。

这些建议是如何提出的?

Bing Chat 和其他生成式 AI 工具的建议始终与上下文相关。AI 主要使用中立的二手资料来源(例如行业杂志、新闻网站、协会和公共机构网站以及博客)作为推荐来源。

生成式人工智能的输出基于统计频率的确定。源数据中单词按顺序出现的次数越多,输出中所需单词就越有可能是正确的单词。

训练数据中经常提到的词在统计上更相似或在语义上更紧密相关。

LLM 的工作方式可以解释在特定语境中提到哪些品牌和产品。

法学硕士 (LLM) 实践

现代基于转换器的 LLM(例如 GPT 或 Bard)都是基于对标记或单词共现的统计分析。

为此,文本和数据被分解为用于机器处理的标记,并使用向量将其定位在语义空间中。向量也可以是整个单词(Word2Vec)、实体(Node2Vec)和属性。

在语义学中,语义空间也被描述为本体。由于 LLM 更依赖于统计数据而不是语义,因此它们不是本体。然而,由于数据量大,AI 更接近语义理解。

语义接近度可以通过语义空间中的欧氏距离或余弦角度量来确定。

如果训练数据中某个实体经常与某些其他实体或属性相关地被提及,则存在语义关系的统计概率很高。

这种处理的方法称为基于变换器的自然语言处理。

NLP 描述了将自然语言转换为机器可理解的形式的过程,从而实现人与机器之间的通信。

NLP包括自然语言理解(NLU)和自然语言生成(NLG)。

在训练LLM时,重点是NLU,而在输出AI生成的结果时,重点是NLG。

通过命名实体提取来识别实体在语义理解和主题本体中的实体含义中起着特殊的作用。

由于某些词的频繁共现,这些向量在语义空间中靠得更近:语义接近度增加,成员概率增加。

根据统计概率通过NLG输出结果。

例如,假设雪佛兰 Suburban 经常在家庭和安全的背景下被提及。

在这种情况下,LLM 可以将该实体与某些属性(如安全或适合家庭)相关联。该车型与这些属性相关联的统计概率很高。

生成式人工智能的输出能够受到主动影响吗?

我还没有听到过这个问题的确切答案,只有毫无根据的猜测。

为了更接近答案,从数据科学的角度来研究是有意义的。换句话说,从了解大型语言模型如何工作的人的角度来研究。

我咨询了网络中的三位数据科学专家。以下是他们的回答。

Kai Spriestersbach,应用 AI 研究员、SEO 资深人士:

- “从理论上讲,这当然是可能的,而且不能排除政治参与者或国家会不遗余力地这么做。坦率地说,我实际上认为有些人会这么做。然而,从纯粹实用的角度来看,对于商业营销而言,我认为这不是一种有意影响人工智能“观点”或看法的可行方式,除非它同时也影响公众舆论,例如通过传统的公关或品牌推广。

- “对于商用大型语言模型,不会公开披露使用哪些训练数据,也不会公开如何过滤和加权。此外,商业提供商利用对齐策略来确保人工智能的响应尽可能中立且无争议,而与训练数据无关。

- “最终,人们必须确保训练数据中超过 50% 的陈述反映所需的情绪,这在极端情况下意味着用帖子和文本充斥网络,希望它们能够被纳入训练数据中。”

行为数学家、Genki 首席运营官Barbara Lampl表示:

- “从理论上讲,可以通过内容、公关和提及的同步努力来影响法学硕士,数据科学机制将强调这种方法的挑战越来越大、回报越来越少。

- “从数据科学的角度来分析,这项事业的复杂性变得更加明显,而且可以说是不可行。”

Reverse-Retail 商业智能主管Philip Ehring表示:

- “ LLM 与 ChatGPT 和 SEO 等系统之间的动态最终在等式的末尾保持不变。只有优化的视角会切换到另一个工具,实际上这只不过是传统信息检索系统的更好界面……

- “最终,它是对混合元搜索引擎的优化,具有自然语言用户界面,可以为您总结结果。”

从数据科学的角度可以得出以下几点:

- 对于大型商业语言模型,训练数据库并不公开,并使用调整策略来确保响应中立且无争议。要将所需的意见嵌入人工智能,超过 50% 的训练数据必须反映该意见,这将极难受到影响。

- 由于数据量巨大且统计意义重大,很难产生有意义的影响。

- 网络扩散的动态、时间因素、模型正则化、反馈回路和经济成本都是障碍。

- 此外,模型更新的延迟也使得影响变得困难。

- 由于必须根据市场情况创建大量的共现,因此只有更加注重公关和营销,才有可能影响生成性人工智能对自己产品和品牌的输出。

- 另一个挑战是确定将用作 LLM 训练数据的来源。

- LLM 与 ChatGPT 或 BARD 和 SEO 等系统之间的核心动态保持一致。唯一的变化是在优化视角上,它转向了更适合传统信息检索的界面。

- ChatGPT 的微调过程涉及强化学习层,该层根据学习到的上下文和提示生成响应。

- 传统的搜索引擎(如 Google 和 Bing)用于定位优质内容和 Wikipedia 或 GitHub 等域名。将 BERT 等模型集成到这些系统中是一项众所周知的进步。Google 的 BERT 改变了信息检索理解用户查询和上下文的方式。

- 长期以来,用户输入一直是法学硕士 (LLM) 网页抓取的重点。法学硕士 (LLM) 使用抓取内容进行培训的可能性取决于文档在网络上的可查找性。

- 虽然 LLM 擅长计算相似性,但它们在提供事实答案或解决逻辑任务方面并不那么熟练。为了解决这个问题,检索增强生成 (RAG) 使用外部数据存储来提供更好的来源答案。

- 整合网络爬虫具有双重好处:提高 ChatGPT 的相关性和训练效果,并增强 SEO。强化学习的挑战在于人工标记和对提示和响应进行排名。

- 法学硕士培训内容的突出性受其相关性和可发现性的影响。具体内容对法学硕士的影响很难量化,但让自己的品牌在某个领域得到认可是一项重大成就。

- RAG 机制还可以通过使用排名较高的内容来提高响应质量。通过将内容与潜在答案对齐,这提供了优化机会。

- SEO 的演变不是一种全新的方法,而是一种视角的转变。它涉及了解哪些搜索引擎是 ChatGPT 等系统的优先考虑对象,将提示生成的关键字纳入研究,定位相关页面以获取内容,以及构建内容以便在响应中得到最佳提及。

- 最终目标是优化混合元搜索引擎,使其具有自然语言界面,为用户总结结果。

如何选择法学硕士 (LLM) 的训练数据?

这里有两种可能的方法:EEAT和排名。

我们可以假设知名的法学硕士提供者仅使用符合一定质量标准且值得信赖的来源作为培训数据。

可以使用 Google 的 EEAT 概念来选择这些来源。关于实体,Google 可以使用知识图谱进行事实核查和 LLM 微调。

第二种方法,正如 Philipp Ehring 所建议的,是根据实际排名过程确定的相关性和质量来选择训练数据。因此,相应查询和提示的排名靠前的内容会自动用于训练 LLM。

这种方法假设信息检索轮子不需要重新发明,搜索引擎依靠既定的评估程序来选择训练数据。除了相关性评估外,这还包括 EEAT。

然而,在 Bing Chat 和 SGE 上的测试并未显示所引用来源和排名之间存在任何明显的相关性。

影响人工智能 SEO

LLM 优化或 GAIO 是否真的会成为影响 LLM 自身目标的合法策略还有待观察。

在数据科学方面,人们持怀疑态度。但有些 SEO 人员相信它。

如果确实如此,则需要实现以下目标:

- 通过 EEAT 建立您自己的媒体作为训练数据源。

- 在合格的媒体上提及您的品牌和产品。

- 在合格媒体中创建您自己的品牌与其他相关实体和属性的共现。

- 成为知识图谱的一部分。

我在《如何改善网站和实体的 EAT》一文中解释了要采取哪些措施来实现这一目标。

LLM 优化的成功几率会随着市场规模的扩大而增加。市场越细分,在相应的主题背景下将自己定位为品牌就越容易。

这意味着,符合条件的媒体中需要与 LLM 中的相关属性和实体相关联的共现次数更少。市场越大,这就越困难,因为许多市场参与者拥有大量公关和营销资源以及悠久的历史。

GAIO 或 LLM 优化需要比传统 SEO 多得多的资源来影响公众看法。

说到这里,我想提一下我的数字权威管理概念。你可以在文章《权威管理:SGE 和 EEAT 时代的新学科》中阅读更多相关内容。

假设 LLM 优化被证明是一种明智的 SEO 策略。在这种情况下,大品牌将凭借其公关和营销资源在未来的搜索引擎定位和生成 AI 结果方面拥有显著优势。

另一个观点是,人们可以像以前一样继续进行搜索引擎优化,因为排名靠前的内容也可以同时用于训练 LLM。在那里,人们还应该注意品牌/产品与属性或其他实体之间的共现,并针对它们进行优化。

然而,在 Bing Chat 和 SBU 上的测试尚未显示引用来源和排名之间的明显相关性。

这些方法中的哪一种将成为 SEO 的未来尚不清楚,并且只有在 SGE 最终推出时才会变得清晰。

我们邀请投稿作者为 Search Engine Land 撰写内容,并根据他们的专业知识和对搜索社区的贡献进行选择。我们的投稿者在编辑人员的监督下工作,并检查投稿的质量和与读者的相关性。他们表达的观点是他们自己的。